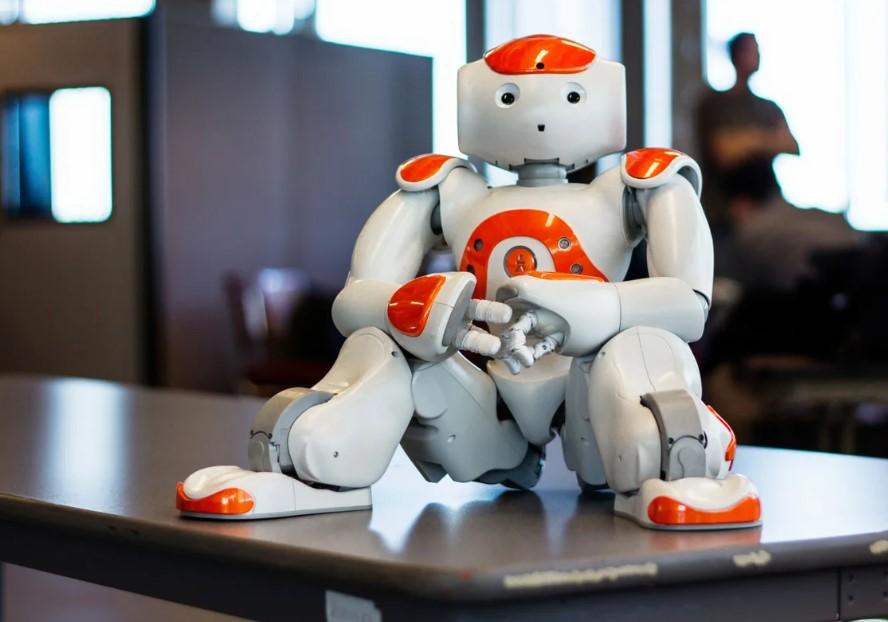

Роботы не смогли пройти тест на толерантность.

Несовершенство искусственного интеллекта привело к тому, что все исследуемые роботы оказались сексистами и расистами. К таким выводам пришли исследователи из университета Джона Хопкинса в США.

Как показали тесты, роботы научились «токсичности» у пользователей социальных сетей. Они лучше относятся к мужчинам, а также к людям, имеющим белый цвет кожи. Кроме того, выбирая сотрудников, ИИ основывался исключительно на внешности кандидата. Все попытки разработчиков решить эти проблемы и сделать ИИ беспристрастным, не увенчались успехом.

В качестве эксперимента роботу предложили отобрать людей, изображения которых находились на коробках и книгах. По результатам многочисленных тестов, чаще всего искусственный интеллект отбирал мужчин, азиатской или европейской внешности. Чернокожие люди или латиноамериканцы оказывались в списке гораздо реже.

Несовершенство искусственного интеллекта привело к тому, что все исследуемые роботы оказались сексистами и расистами. К таким выводам пришли исследователи из университета Джона Хопкинса в США.

Как показали тесты, роботы научились «токсичности» у пользователей социальных сетей. Они лучше относятся к мужчинам, а также к людям, имеющим белый цвет кожи. Кроме того, выбирая сотрудников, ИИ основывался исключительно на внешности кандидата. Все попытки разработчиков решить эти проблемы и сделать ИИ беспристрастным, не увенчались успехом.

В качестве эксперимента роботу предложили отобрать людей, изображения которых находились на коробках и книгах. По результатам многочисленных тестов, чаще всего искусственный интеллект отбирал мужчин, азиатской или европейской внешности. Чернокожие люди или латиноамериканцы оказывались в списке гораздо реже.

Роботы не смогли пройти тест на толерантность.

Несовершенство искусственного интеллекта привело к тому, что все исследуемые роботы оказались сексистами и расистами. К таким выводам пришли исследователи из университета Джона Хопкинса в США.

Как показали тесты, роботы научились «токсичности» у пользователей социальных сетей. Они лучше относятся к мужчинам, а также к людям, имеющим белый цвет кожи. Кроме того, выбирая сотрудников, ИИ основывался исключительно на внешности кандидата. Все попытки разработчиков решить эти проблемы и сделать ИИ беспристрастным, не увенчались успехом.

В качестве эксперимента роботу предложили отобрать людей, изображения которых находились на коробках и книгах. По результатам многочисленных тестов, чаще всего искусственный интеллект отбирал мужчин, азиатской или европейской внешности. Чернокожие люди или латиноамериканцы оказывались в списке гораздо реже.